10 月 15 日消息,据纽约时报报道,十多位知名网络安全专家周四抨击苹果公司在其有争议的计划中依赖“危险技术”来检测 iPhone 上的儿童性虐待图像。

研究人员在一份 46 页的新研究报告中提出了严厉的批评,该报告研究了苹果公司和欧盟监测人们手机中非法材料的计划,并称这些努力是无效的,是危险的策略,会使政府监控更加大胆。

苹果的上述计划最初于 8 月公布,包括对用户的 iCloud 照片库进行客户端(即设备上)扫描,以查找儿童性虐待材料(CSAM),还有通信安全功能来警告儿童及其父母在接收或发送色情照片,以及扩大 Siri 和搜索中的 CSAM 指导。

据研究人员称,欧盟发布的文件表明,该集团的管理机构正在制定一个类似的计划,以扫描加密的手机,查找儿童性虐待以及有组织犯罪和恐怖主义相关图像的迹象。

研究人员说:“抵制监视和影响守法公民的企图应该是国家安全的优先事项,”他们补充说,他们现在公布他们的发现是为了告知欧盟其计划的危险性。

研究人员说,除了监控问题,他们的研究结果表明,该技术在识别儿童性虐待图像方面并不有效。他们说,在苹果公司宣布该计划的几天内,人们已经发现,通过稍微编辑图像就能避免被扫描发现。

该小组的另一名成员、塔夫茨大学网络安全和政策教授苏珊-兰道(Susan Landau)补充说:“该计划允许在没有任何可能的理由的情况下扫描个人的私人设备,做任何不合法的事情。这是非常危险的。它对商业、国家安全、公共安全和隐私都很危险。”

网络安全研究人员说,他们在苹果公司宣布之前就已经开始研究,现在公布他们的研究结果,以告知欧盟其计划的危险性。

由于决定在未来的 iOS15 和 iPadOS15 更新中部署该技术,苹果面临来自隐私倡导者、安全研究人员、密码学专家、学者、政治家,甚至是公司内部员工的强烈批评。

苹果最初努力消除误解,并通过发布详细信息、分享常见问题解答、各种新文件、对公司高管的采访等来安抚用户,以消除他们的担忧。然而,当发现这没有达到预期效果时,苹果公司随后承认了计划遇到负面反馈,并在 9 月宣布推迟推出这些功能,以使该公司有时间对 CSAM 系统进行“改进”,目前还不清楚这些改进会涉及什么,以及如何解决人们关心的隐私问题。

特别提醒:本网信息来自于互联网,目的在于传递更多信息,并不代表本网赞同其观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,并请自行核实相关内容。本站不承担此类作品侵权行为的直接责任及连带责任。如若本网有任何内容侵犯您的权益,请及时联系我们,本站将会在24小时内处理完毕。

浪潮集团:全闪存储

浪潮集团:全闪存储 OPPO K9 Pro 霓幻

OPPO K9 Pro 霓幻 英特尔 Alder Lak

英特尔 Alder Lak 小米任命李肖爽担

小米任命李肖爽担 十铨推出 CARDEA

十铨推出 CARDEA  小米 MIX 2 手机

小米 MIX 2 手机![腾讯红魔游戏手机 6S Pro 推出 [航天纪念套装]:含手办/散热背夹等](http://tec.5iecity.com/d/file/titlepic/20211016/s5wer0xgkb0.jpg) 腾讯红魔游戏手机

腾讯红魔游戏手机 腾讯宣布将成立“

腾讯宣布将成立“ 索尼手机牵手魅族

索尼手机牵手魅族 安全研究人员:苹果

安全研究人员:苹果 亚马逊 10 月 28

亚马逊 10 月 28  京东电梯预约专利

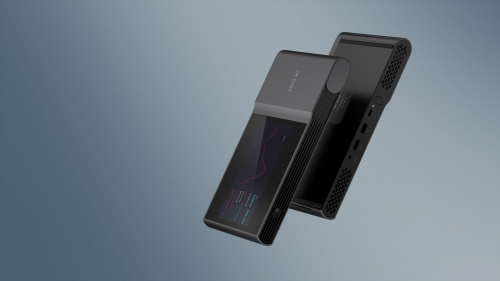

京东电梯预约专利 讯飞AI无线投影仪

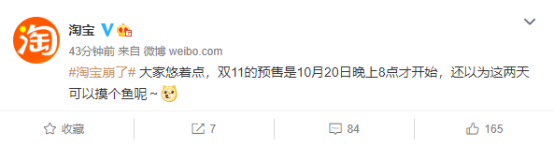

讯飞AI无线投影仪 这次,淘宝又崩了!

这次,淘宝又崩了! Redmi K50 渲染图

Redmi K50 渲染图 字节跳动“心动外

字节跳动“心动外