在AI向前不断推进的过程中,随着业界对AI应用落地的迫切需求,AI软硬件的充分结合势在必行。瑞芯微高算力AI芯片与百度飞桨开源深度平台之间的合作,强势赋能AI行业。

就在5月13日,瑞芯微Rockchip正式宣布,旗下AI芯片RK1808、RK1806适配百度飞桨(PaddlePaddle)开源深度学习平台,充分兼容飞桨轻量化推理引擎Paddle Lite。双方的合作为AI应用与场景的落地,打下着坚实基础。

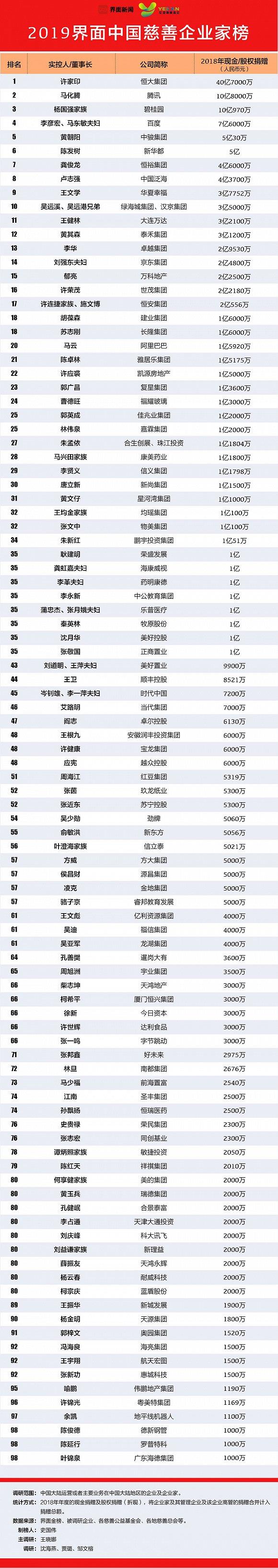

百度飞桨与瑞芯微兼容性认证书

其中,瑞芯微AI芯片经过多年发展之后,在稳定性、兼容性和成熟度等方面有着长足进步。本次合作的瑞芯微AI芯片RK1808及RK1806,内置独立NPU神经计算单元,INT8 算力高达3.0TOPs。而采用22nm FD-SOI工艺,让这两款芯片在相同性能下的功耗相比主流28nm工艺产品降低约30%,算力、性能、功耗等表现不错。

飞桨产业级深度学习开源平台,则以百度多年的深度学习技术研究和产业应用为基础,是颇具影响力的产业级深度学习平台。Paddle Lite则是飞桨推出的轻量化推理引擎,支持多种硬件、多种平台,具备轻量化部署、高性能实现等特性。这个引擎能为AI芯片,附加强有力的“灵魂”。

瑞芯微RK18xx系列芯片适配Paddle Lite

数据,能说明一切。经实测,瑞芯微AI芯片在Paddle Lite中运行MobileNet V1耗时仅为6.5 ms,帧率高达153.8 FPS,二者充分兼容并高效稳定运行。如下图所示的实测结果,与手机等移动端常用的国内外主流CPU相比,RK18系列NPU在MobileNET_v1的耗时更少,表现出色。这能够证明,在AI相关领域,如图像分类、目标检测、语音交互上,专用AI芯片将带来更出色的效果。由此,AI应用自然能够加速落地。

瑞芯微RK18xx系列芯片在MobileNETV1上对比主流CPU性能卓越

随着AI行业的不断前行,相关的软硬件充分结合,必然能在生态层面发挥出更大效能。届时,AI应用、场景也将变得更为多元化,也更能满足业界和消费者的需求。

目前,在Paddle Lite文档上,已经可详细查询到瑞芯微AI芯片在飞桨上的实操教程(搜索路径:百度搜索“Paddle-Lite 文档”,左下角选择版本release-v2.6.0,部署案例板块“PaddleLite使用RK NPU预测部署”)。瑞芯微旗下搭载NPU的AI系列芯片将陆续升级适配百度飞桨,进一步深化双方合作关系!

特别提醒:本网内容转载自其他媒体,目的在于传递更多信息,并不代表本网赞同其观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,并请自行核实相关内容。本站不承担此类作品侵权行为的直接责任及连带责任。如若本网有任何内容侵犯您的权益,请及时联系我们,本站将会在24小时内处理完毕。

瑞芯微与百度飞桨

瑞芯微与百度飞桨 Epic Games 公布

Epic Games 公布 索尼第二款8K智能

索尼第二款8K智能 Chrome新功能标签

Chrome新功能标签 Redmi K30极速版

Redmi K30极速版 刘涛直播首秀半价

刘涛直播首秀半价 OPPO三款无线耳机

OPPO三款无线耳机 一键智能识别垃圾

一键智能识别垃圾 京东送来的护士节

京东送来的护士节 荣耀30系列重“锤

荣耀30系列重“锤 WAVE SUMMIT 2020

WAVE SUMMIT 2020 华为在浙加速布局

华为在浙加速布局 微赞直播加入腾讯

微赞直播加入腾讯 瑞芯微AI芯片加持

瑞芯微AI芯片加持