11月6日,由中国中文信息学会(CIPS)和中国计算机学会(CCF)联合主办的“第五届语言与智能高峰论坛”在线举行。大会同期为“2020语言与智能技术竞赛”五大任务领域优秀团队授奖,凭借在阅读理解技术方向的深厚积累,云知声认知智能团队摘得机器阅读理解任务冠军奖牌。

“2020语言与智能技术竞赛”由中国中文信息学会(CIPS)和中国计算机学会(CCF)联合主办,百度公司、中国中文信息学会评测工作委员会和中国计算机学会中文信息技术专委会联合承办,设立机器阅读理解、面向推荐的对话、关系抽取、语义解析与事件抽取五大热门竞赛任务,并提供面向真实应用场景的大规模数据集。

今年的参赛规模创历年新高,五大任务领域累计报名参赛队伍超5300支,参赛选手超6000人,大赛累积收到有效提交结果近15000份,成为中文NLP领域参赛人数最多的赛事。除整体参赛人数规模翻倍之外,参赛队伍阵容亦堪称豪华,覆盖了海内外知名高校、科研机构以及诸多知名企业。

作为本次竞赛的核心任务之一,机器阅读理解 (Machine Reading Comprehension)是指让机器阅读文本,然后回答和阅读内容相关的问题。阅读理解是自然语言处理和人工智能领域的重要前沿课题,对于提升机器的智能水平,使机器具有持续获取知识的能力等方面具有重要价值,近年来受到学术界和工业界的广泛关注。本次大赛机器阅读理解评测是连续举办多年的一个任务,吸引了包括中国科学技术大学、中国科学院大学等一千多支知名校企队伍参加。

本次大赛的机器阅读理解任务注重阅读理解模型在真实应用场景中的鲁棒性,挑战模型的过敏感性、过稳定性以及泛化能力。比赛过程中,云知声认知智能团队依托自身雄厚的技术积累,以及在医疗等领域的产业化实战经验,所提交系统取得F1值较基线提升26%的佳绩,在预赛和复赛F1值和EM值在均位列第一。

比赛中,云知声认知智能团队针对阅读理解系统存在的过敏感、过稳定和泛化性不足三个问题进行了有针对性的优化,增强了阅读理解系统在真实场景中的鲁棒性;团队还借助云知声预训练语言模型平台UniPLM,对模型进行了快速迭代和高效训练;最后利用模型集成的方法进一步提高了阅读理解模型的性能指标。

1. 利用数据增强的方法来处理过敏感、过稳定问题。针对过敏感问题,使用问句生成和相似度匹配模型两阶段过程后生成候选样本,用来攻击训练好的阅读理解模型,若攻击成功则生成过敏感类型的增强样本。针对过稳定问题,使用实体识别方法从文章中识别与答案相关实体,与问句信息结合融入篇章中生成候选样本,用来攻击训练好的阅读理解模型,若攻击成功则生成过稳定类型的增强样本。

2. 利用领域外数据来增强模型的泛化能力。增加了包括DuReader、CMRC等通用领域的语料。还增加了证券公告、五种学科的教育领域数据。

3. 借助云知声预训练语言模型平台UniPLM来进行模型的快速迭代和高效训练。UniPLM基于Huggingface的transformers库进行开发,支持各类主流的预训练语言模型以及分类、序列标注、阅读理解等NLP任务。UniPLM融合了TensorBoard和微软NNI框架,支持可视化训练和自动调调参。它还可以高效地在分布式训练平台Atlas上进行多机多卡训练。

让机器理解人类语言是人类长期以来的梦想,也是人工智能应用必须迎接的挑战。作为云知声全栈技术版图的重要模块,经过多年的持续投入与潜心研发,当前云知声认知智能技术已处行业领先水平,由云知声与中科院自动化所合作完成的项目——“大规模知识图谱构建关键技术与应用”亦荣获2019年北京市科学技术进步一等奖。相关技术成果也已先后应用至医疗、家居、车载等诸多垂直领域。

特别提醒:本网内容转载自其他媒体,目的在于传递更多信息,并不代表本网赞同其观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,并请自行核实相关内容。本站不承担此类作品侵权行为的直接责任及连带责任。如若本网有任何内容侵犯您的权益,请及时联系我们,本站将会在24小时内处理完毕。

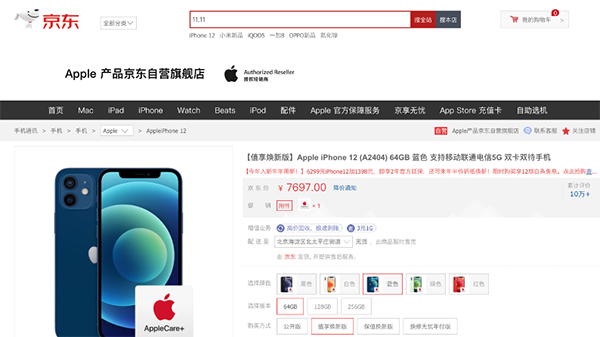

11.11京东手机小

11.11京东手机小 双11最佳入手时机

双11最佳入手时机 美的发布家用冷柜

美的发布家用冷柜 HPE 朱海翔:如何在

HPE 朱海翔:如何在 京东成为Apple首

京东成为Apple首 杨超越领衔超级福

杨超越领衔超级福 国美11.11超低价

国美11.11超低价  快讯!北京卫视苏宁

快讯!北京卫视苏宁 双11蓄“电”待发

双11蓄“电”待发 2020语言与智能技

2020语言与智能技 3.5元寄全国?!快递1

3.5元寄全国?!快递1 限量4折宽带还不

限量4折宽带还不 京东超市与达能纽

京东超市与达能纽 双十一TWS耳机剁

双十一TWS耳机剁 OpenRazer 2.9发

OpenRazer 2.9发 新东方正式登陆港

新东方正式登陆港